Argo workflow v.s. Tekton

在云原生的世界里,持续集成/持续交付(CI/CD)工具起着至关重要的作用,Argo和Tekton作为两款备受瞩目的工具,各自具有独特的特点和优势。本文将从多个方面对它们进行详细对比,帮助大家更好地理解和选择适合自己项目的 CI/CD 解决方案。

Argo核心概念

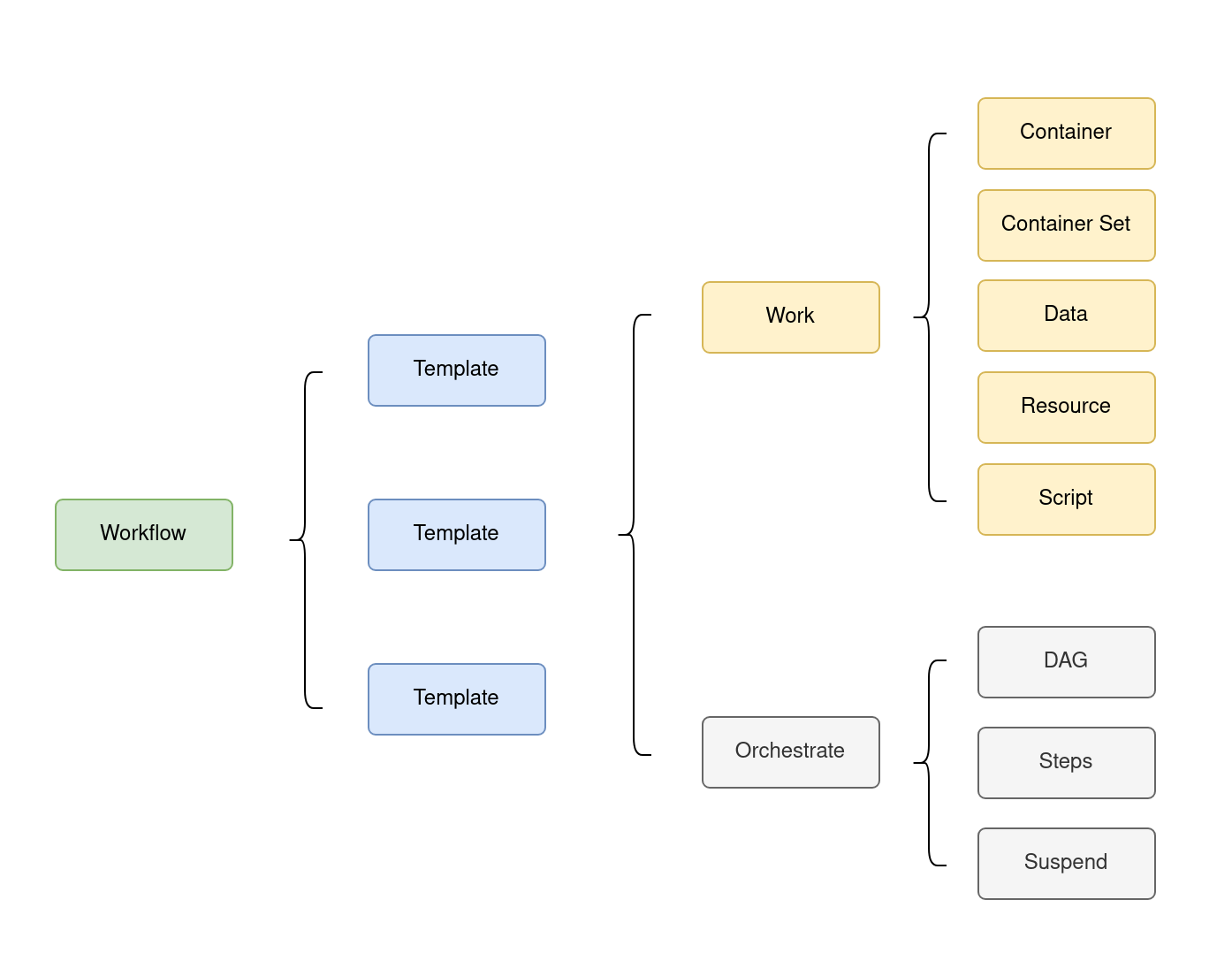

- Workflow: Workflow是Argo管理和调度的对象,用户可以通过UI和CLI提交一个Workflow让Argo去运行。一个Workflow作为Kubernetes CRD来实现。

- Template:一个Workflow可以定义一个或者多个Template,通常会以Pod的形式来运行。入口template可以通过

entrypoint来指定。 - Template tags: 也称为Template variables。它由

{{}}来分割并在运行时被替换为具体的值。 - Template有两种类型,一种是Work,另外一种是Orchestrate。

- Work类型的template有以下几种, 它们都会以Pod的形式来运行:

- container set允许Pod中运行多个容器.

- data template用来从后端存储系统中获取数据。

- resource template可以用来在Kubernetes中创建资源并等待它进入到某一种状态.

- script template可以在容器中运行script。

- Orchestrate类型的template有以下几种:

- DAG有向无循环图,它可以用来指定template之间的依赖关系。

- steps template是一种定义工作流中顺序执行步骤的方式。它是一种线性的任务编排结构,每个步骤(Step)通常是一个容器化的任务,这些任务会按照定义的顺序依次执行

- Suspend template允许用户在工作流执行过程中暂停某个特定任务模板(template)的执行。这提供了一种灵活的机制,用于在需要人工干预、等待外部条件满足或者进行动态调整时,暂停工作流中某个步骤的运行。

- 类似于ansible,template中也可以通过

withItems、withSequence来实现迭代,通过when来实现条件分支。

Tekton核心概念

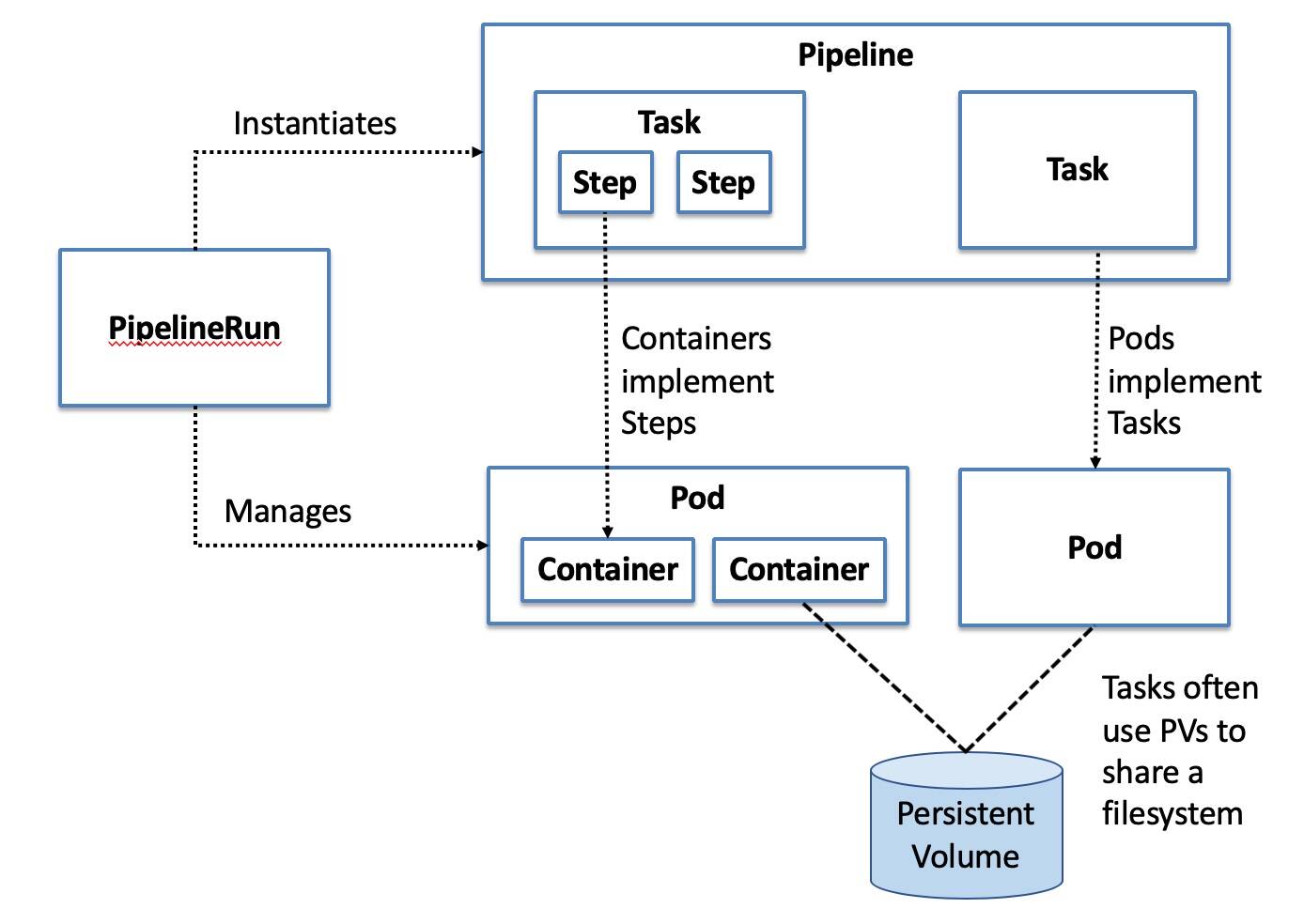

- Task: 定义了一系列有序的步骤(step),并且每个步骤都会针对特定的一组输入调用特定的构建工具,并生成特定的一组输出,这些输出可作为下一步骤的输入使用。

- Pipeline: 支持有向五循环图(DAG),定义了一系列有序的任务,就如同任务中的步骤一样,Pipeline中的一个任务可以使用先前已执行任务的输出作为其输入。

- TaskRun: 实例化一个特定的任务,使其基于特定的一组输入来执行,并生成特定的一组输出。换句话说,任务告知Tekton要做什么,而TaskRun则告知Tekton针对什么来执行任务,以及关于具体如何执行的任何附加细节,例如构建标志。

- PipelineRun: 实例化一个特定的流水线,使其基于特定的一组输入来执行,并将产生的特定一组输出发送至特定的目标位置。

- 通常来说,Step对应一个容器,Task对应一个Pod,Pipeline对应一组Pod

核心功能对比

任务定义与复用

- Tekton:在 Tekton 中,任务被定义为一系列有序的步骤,每个步骤都可以调用特定的容器镜像来执行特定的操作。任务可以通过共享任务库的方式进行复用,这使得团队能够在不同的流水线中重复使用已有的任务逻辑,提高了开发效率并减少了代码冗余。例如,一个用于代码编译的任务可以在多个不同的 CI 流水线中被重复引用,只需要根据不同的项目进行简单的参数配置即可。

- Argo Workflow:Argo Workflow 允许用户通过模板来定义任务,这些模板可以是容器模板、资源模板或者脚本模板等。用户可以将常用的任务逻辑封装成模板,并在不同的工作流中进行复用。与 Tekton 不同的是,Argo Workflow 的模板定义更加灵活,支持更多的参数化配置和动态生成任务的方式,这使得它在处理一些复杂的、需要根据运行时状态动态调整任务的场景中具有优势。

工作流编排灵活性

- Tekton:通过 Pipeline 资源,Tekton 支持将多个任务按照特定的顺序组合成一个完整的工作流。任务之间可以通过定义输入和输出资源来实现数据的传递和依赖关系的管理。这种基于资源的依赖管理方式使得工作流的编排更加清晰和易于理解,同时也方便了对工作流的调试和维护。例如,在一个 CI/CD 流水线中,代码构建任务的输出(如构建后的镜像)可以作为部署任务的输入,Tekton 能够很好地处理这种任务之间的依赖关系,确保工作流按照预期的顺序执行。

- Argo Workflow:借助 DAG 的强大功能,Argo Workflow 能够支持更加复杂的工作流拓扑结构,包括并行分支、条件判断等。用户可以根据业务需求灵活地定义任务之间的执行顺序和依赖关系,实现高度定制化的工作流。例如,在一个数据处理工作流中,可能需要根据数据的不同特征执行不同的处理步骤,Argo Workflow 的 DAG 特性可以轻松地实现这种复杂的逻辑控制,使得工作流能够根据实际情况动态地调整执行路径。

用户界面与可视化

- Tekton:Tekton 本身并没有提供一个完整的用户界面(UI),但它与许多流行的 Kubernetes 仪表板(如 Kubeflow Pipelines UI)集成良好,通过这些集成,用户可以方便地查看和管理 Tekton 工作流的执行状态、查看任务日志等。这种基于第三方 UI 的方式虽然在一定程度上依赖于其他工具,但也使得 Tekton 能够充分利用现有的成熟可视化解决方案,为用户提供相对友好的操作体验。

- Argo Workflow:Argo Workflow 自带了一个功能丰富的用户界面,用户可以通过该 UI 直观地创建、编辑和监控工作流的执行情况。UI 中提供了详细的工作流拓扑图展示,使得用户能够清晰地了解工作流中各个任务的执行状态和依赖关系。此外,Argo Workflow 的 UI 还支持工作流的暂停、恢复和终止等操作,方便用户在运行时对工作流进行灵活的控制,这对于一些需要人工干预的工作流场景来说非常实用。

生态系统集成

- Tekton:作为 CNCF 的项目,Tekton 与其他云原生工具和平台具有良好的集成性。它可以与 Kubernetes 生态系统中的各种工具(如 Helm、Istio 等)无缝协作,同时也支持与主流的 CI/CD 工具(如 Jenkins、GitLab CI 等)集成,使得用户可以将 Tekton 融入到现有的开发流程中,充分利用已有的技术栈。例如,通过与 Jenkins 的集成,用户可以在 Jenkins 中触发 Tekton 流水线的执行,实现更加灵活和强大的 CI/CD 解决方案。

- Argo Workflow:Argo Workflow 也积极地与其他工具进行集成,它与 Kubernetes 的各种资源对象紧密结合,能够方便地调用和管理其他 Kubernetes 资源,如 ConfigMap、Secret 等。此外,Argo Workflow 还支持与一些数据处理和机器学习框架(如 Spark、TensorFlow 等)集成,为数据科学家和工程师提供了一个强大的工作流编排平台,用于构建和运行复杂的数据处理和机器学习流水线。

适用场景对比

- Tekton:在大型企业的 CI/CD 场景中,Tekton 表现出色。例如,一个拥有多个微服务项目的团队,可以使用 Tekton 来构建统一的 CI/CD 平台。通过定义通用的任务(如代码拉取、构建、测试、部署等)并将它们组合成不同的流水线,团队可以快速地为每个微服务项目创建定制化的交付流程,同时保证整个平台的可维护性和扩展性。另外,Tekton 在云原生应用的持续交付过程中,能够与 Kubernetes 的各种资源和工具进行深度集成,实现从代码提交到应用上线的全自动化流程,大大提高了开发效率和交付速度。

- Argo Workflow:对于数据处理和机器学习工作流,Argo Workflow 是一个不错的选择。例如,在一个数据分析团队中,需要定期从多个数据源获取数据,进行清洗、转换和分析,并将结果存储到数据仓库中。Argo Workflow 可以通过其灵活的 DAG 编排能力,定义一个复杂的数据处理流水线,包括数据采集任务、数据清洗任务、数据分析任务以及结果存储任务等,各个任务之间可以根据数据的依赖关系进行并行或顺序执行,确保整个数据处理流程的高效和准确。此外,在机器学习模型训练和部署的场景中,Argo Workflow 也能够很好地管理模型训练的各个阶段,包括数据预处理、模型训练、模型评估以及模型上线等,为机器学习工程师提供了一个强大的工具来构建和管理复杂的机器学习工作流。

小结

Tekton 和 Argo Workflow 都是优秀的工作流编排工具,它们在架构设计、功能特性、用户界面以及生态系统集成等方面都存在着各自的优势和适用场景。Tekton 凭借其高度模块化和可扩展的设计,以及与 Kubernetes 生态系统的紧密集成,在 CI/CD 领域具有很强的竞争力;而 Argo Workflow 则以其灵活的 DAG 编排能力和丰富的可视化界面,在数据处理和机器学习工作流方面表现出色。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 三木的技术博客!

评论